TensorFlow模型¶

本章介绍如何使用TensorFlow快速搭建动态模型。

前置知识:

- Python面向对象 (在Python内定义类和方法、类的继承、构造和析构函数,使用super()函数调用父类方法 ,使用__call__()方法对实例进行调用 等);

- 多层感知机、卷积神经网络、循环神经网络和强化学习(每节之前给出参考资料)。

模型(Model)与层(Layer)¶

如上一章所述,为了增强代码的可复用性,我们往往会将模型编写为类,然后在模型调用的地方使用 y_pred = model(X) 的形式进行调用。 模型类 的形式非常简单,主要包含 __init__() (构造函数,初始化)和 call(input) (模型调用)两个方法,但也可以根据需要增加自定义的方法。 [1]

class MyModel(tf.keras.Model):

def __init__(self):

super().__init__() # Python 2 下使用 super(MyModel, self).__init__()

# 此处添加初始化代码(包含call方法中会用到的层)

def call(self, inputs):

# 此处添加模型调用的代码(处理输入并返回输出)

return output

在这里,我们的模型类继承了 tf.keras.Model 。Keras是一个用Python编写的高级神经网络API,现已得到TensorFlow的官方支持和内置。继承 tf.keras.Model 的一个好处在于我们可以使用父类的若干方法和属性,例如在实例化类后可以通过 model.variables 这一属性直接获得模型中的所有变量,免去我们一个个显式指定变量的麻烦。

同时,我们引入 “层”(Layer) 的概念,层可以视为比模型粒度更细的组件单位,将计算流程和变量进行了封装。我们可以使用层来快速搭建模型。

上一章中简单的线性模型 y_pred = tf.matmul(X, w) + b ,我们可以通过模型类的方式编写如下:

import tensorflow as tf

tf.enable_eager_execution()

X = tf.constant([[1.0, 2.0, 3.0], [4.0, 5.0, 6.0]])

y = tf.constant([[10.0], [20.0]])

class Linear(tf.keras.Model):

def __init__(self):

super().__init__()

self.dense = tf.keras.layers.Dense(units=1, kernel_initializer=tf.zeros_initializer(),

bias_initializer=tf.zeros_initializer())

def call(self, input):

output = self.dense(input)

return output

# 以下代码结构与前节类似

model = Linear()

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.01)

for i in range(100):

with tf.GradientTape() as tape:

y_pred = model(X) # 调用模型

loss = tf.reduce_mean(tf.square(y_pred - y))

grads = tape.gradient(loss, model.variables)

optimizer.apply_gradients(grads_and_vars=zip(grads, model.variables))

print(model.variables)

这里,我们没有显式地声明 w 和 b 两个变量并写出 y_pred = tf.matmul(X, w) + b 这一线性变换,而是在初始化部分实例化了一个全连接层( tf.keras.layers.Dense ),并在call方法中对这个层进行调用。全连接层封装了 output = activation(tf.matmul(input, kernel) + bias) 这一线性变换+激活函数的计算操作,以及 kernel 和 bias 两个变量。当不指定激活函数时(即 activation(x) = x ),这个全连接层就等价于我们上述的线性变换。顺便一提,全连接层可能是我们编写模型时使用最频繁的层。

如果我们需要显式地声明自己的变量并使用变量进行自定义运算,请参考 自定义层。

| [1] | 在Python类中,对类的实例 myClass 进行形如 myClass() 的调用等价于 myClass.__call__() 。在这里,我们的模型继承了 tf.keras.Model 这一父类。该父类中包含 __call__() 的定义,其中调用了 call() 方法,同时进行了一些keras的内部操作。这里,我们通过继承 tf.keras.Model 并重载 call() 方法,即可在保持keras结构的同时加入模型调用的代码。具体请见本章初“前置知识”的 __call__() 部分。 |

基础示例:多层感知机(MLP)¶

我们从编写一个最简单的 多层感知机 (Multilayer Perceptron, MLP)开始,介绍TensorFlow的模型编写方式。这里,我们使用多层感知机完成MNIST手写体数字图片数据集 [LeCun1998] 的分类任务。

MNIST手写体数字图片示例

先进行预备工作,实现一个简单的 DataLoader 类来读取MNIST数据集数据。

class DataLoader():

def __init__(self):

mnist = tf.contrib.learn.datasets.load_dataset("mnist")

self.train_data = mnist.train.images # np.array [55000, 784]

self.train_labels = np.asarray(mnist.train.labels, dtype=np.int32) # np.array [55000] of int32

self.eval_data = mnist.test.images # np.array [10000, 784]

self.eval_labels = np.asarray(mnist.test.labels, dtype=np.int32) # np.array [10000] of int32

def get_batch(self, batch_size):

index = np.random.randint(0, np.shape(self.train_data)[0], batch_size)

return self.train_data[index, :], self.train_labels[index]

多层感知机的模型类实现与上面的线性模型类似,所不同的地方在于层数增加了(顾名思义,“多层”感知机),以及引入了非线性激活函数(这里使用了 ReLU函数 , 即下方的 activation=tf.nn.relu )。该模型输入一个向量(比如这里是拉直的1×784手写体数字图片),输出10维的信号,分别代表这张图片属于0到9的概率。这里我们加入了一个predict方法,对图片对应的数字进行预测。在预测的时候,选择概率最大的数字进行预测输出。

class MLP(tf.keras.Model):

def __init__(self):

super().__init__()

self.dense1 = tf.keras.layers.Dense(units=100, activation=tf.nn.relu)

self.dense2 = tf.keras.layers.Dense(units=10)

def call(self, inputs):

x = self.dense1(inputs)

x = self.dense2(x)

return x

def predict(self, inputs):

logits = self(inputs)

return tf.argmax(logits, axis=-1)

定义一些模型超参数:

num_batches = 1000

batch_size = 50

learning_rate = 0.001

实例化模型,数据读取类和优化器:

model = MLP()

data_loader = DataLoader()

optimizer = tf.train.AdamOptimizer(learning_rate=learning_rate)

然后迭代进行以下步骤:

- 从DataLoader中随机取一批训练数据;

- 将这批数据送入模型,计算出模型的预测值;

- 将模型预测值与真实值进行比较,计算损失函数(loss);

- 计算损失函数关于模型变量的导数;

- 使用优化器更新模型参数以最小化损失函数。

具体代码实现如下:

for batch_index in range(num_batches):

X, y = data_loader.get_batch(batch_size)

with tf.GradientTape() as tape:

y_logit_pred = model(tf.convert_to_tensor(X))

loss = tf.losses.sparse_softmax_cross_entropy(labels=y, logits=y_logit_pred)

print("batch %d: loss %f" % (batch_index, loss.numpy()))

grads = tape.gradient(loss, model.variables)

optimizer.apply_gradients(grads_and_vars=zip(grads, model.variables))

接下来,我们使用验证集测试模型性能。具体而言,比较验证集上模型预测的结果与真实结果,输出预测正确的样本数占总样本数的比例:

num_eval_samples = np.shape(data_loader.eval_labels)[0]

y_pred = model.predict(data_loader.eval_data).numpy()

print("test accuracy: %f" % (sum(y_pred == data_loader.eval_labels) / num_eval_samples))

输出结果:

test accuracy: 0.947900

可以注意到,使用这样简单的模型,已经可以达到95%左右的准确率。

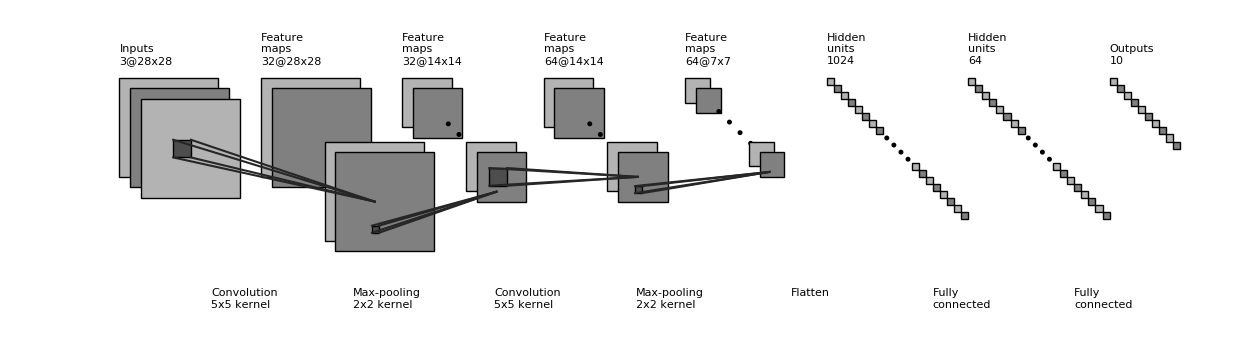

卷积神经网络(CNN)¶

卷积神经网络 (Convolutional Neural Network, CNN)是一种结构类似于人类或动物的 视觉系统 的人工神经网络,包含一个或多个卷积层(Convolutional Layer)、池化层(Pooling Layer)和全连接层(Dense Layer)。具体原理建议可以参考台湾大学李宏毅教授的《机器学习》课程的 Convolutional Neural Network 一章。

具体的实现见下,和MLP很类似,只是新加入了一些卷积层和池化层。

CNN结构图示

class CNN(tf.keras.Model):

def __init__(self):

super().__init__()

self.conv1 = tf.keras.layers.Conv2D(

filters=32, # 卷积核数目

kernel_size=[5, 5], # 感受野大小

padding="same", # padding策略

activation=tf.nn.relu # 激活函数

)

self.pool1 = tf.keras.layers.MaxPool2D(pool_size=[2, 2], strides=2)

self.conv2 = tf.keras.layers.Conv2D(

filters=64,

kernel_size=[5, 5],

padding="same",

activation=tf.nn.relu

)

self.pool2 = tf.keras.layers.MaxPool2D(pool_size=[2, 2], strides=2)

self.flatten = tf.keras.layers.Reshape(target_shape=(7 * 7 * 64,))

self.dense1 = tf.keras.layers.Dense(units=1024, activation=tf.nn.relu)

self.dense2 = tf.keras.layers.Dense(units=10)

def call(self, inputs):

inputs = tf.reshape(inputs, [-1, 28, 28, 1])

x = self.conv1(inputs) # [batch_size, 28, 28, 32]

x = self.pool1(x) # [batch_size, 14, 14, 32]

x = self.conv2(x) # [batch_size, 14, 14, 64]

x = self.pool2(x) # [batch_size, 7, 7, 64]

x = self.flatten(x) # [batch_size, 7 * 7 * 64]

x = self.dense1(x) # [batch_size, 1024]

x = self.dense2(x) # [batch_size, 10]

return x

def predict(self, inputs):

logits = self(inputs)

return tf.argmax(logits, axis=-1)

将前节的 model = MLP() 更换成 model = CNN() ,输出如下:

test accuracy: 0.988100

可以发现准确率有非常显著的提高。事实上,通过改变模型的网络结构(比如加入Dropout层防止过拟合),准确率还有进一步提升的空间。

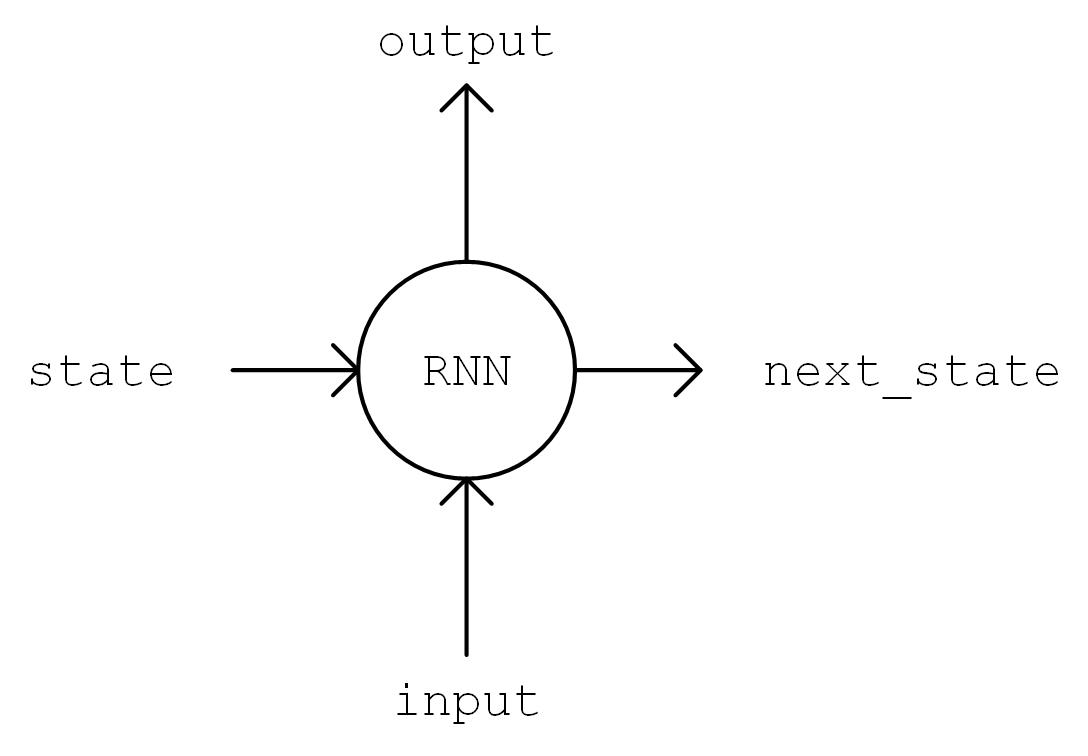

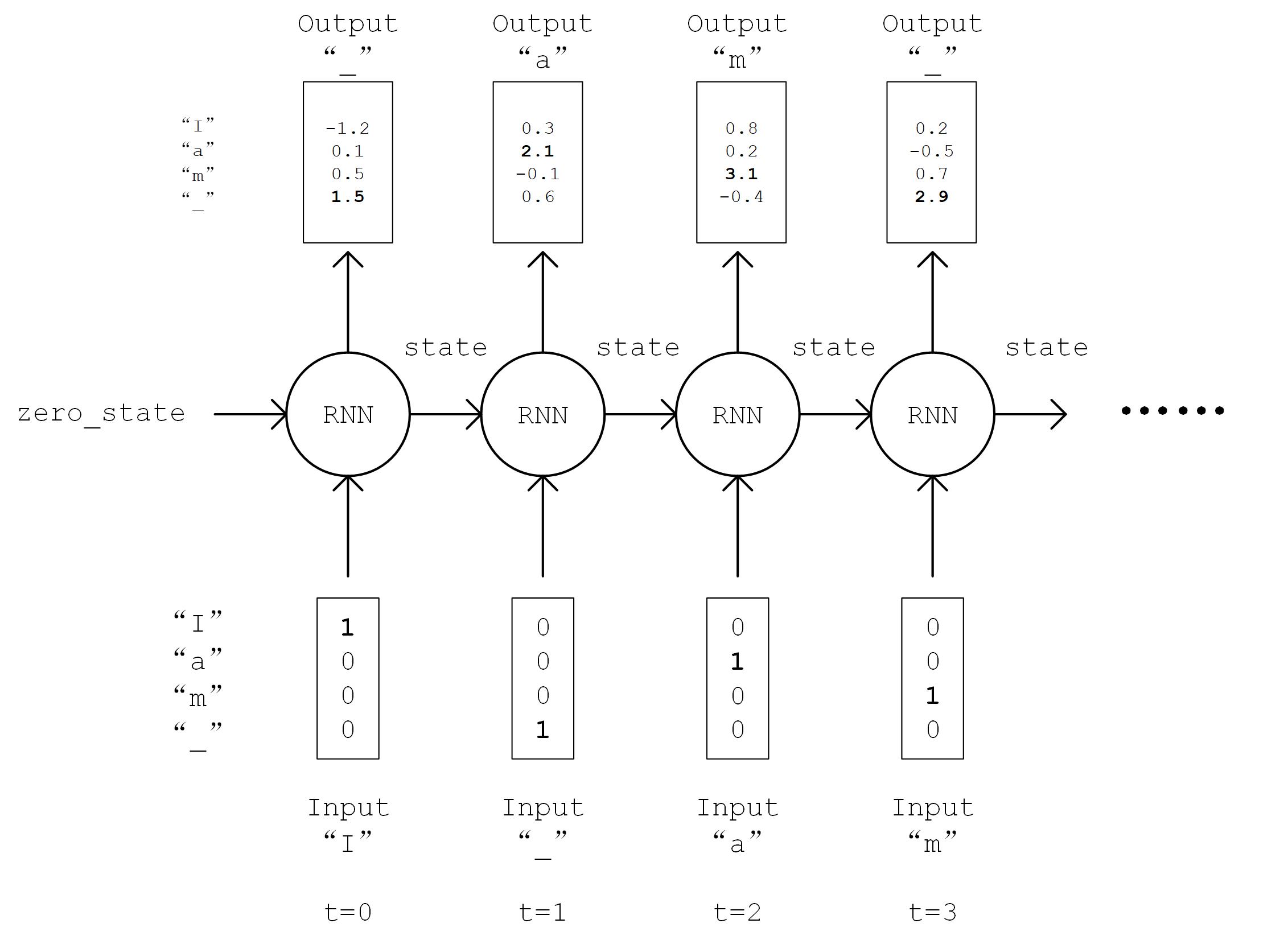

循环神经网络(RNN)¶

循环神经网络(Recurrent Neural Network, RNN)是一种适宜于处理序列数据的神经网络,被广泛用于语言模型、文本生成、机器翻译等。关于RNN的原理,可以参考:

- Recurrent Neural Networks Tutorial, Part 1 – Introduction to RNNs

- 台湾大学李宏毅教授的《机器学习》课程的 Recurrent Neural Network (part 1) Recurrent Neural Network (part 2) 两部分。

- LSTM原理:Understanding LSTM Networks

- RNN序列生成:[Graves2013]

这里,我们使用RNN来进行尼采风格文本的自动生成。 [2]

这个任务的本质其实预测一段英文文本的接续字母的概率分布。比如,我们有以下句子:

I am a studen

这个句子(序列)一共有13个字符(包含空格)。当我们阅读到这个由13个字符组成的序列后,根据我们的经验,我们可以预测出下一个字符很大概率是“t”。我们希望建立这样一个模型,输入num_batch个由编码后字符组成的,长为seq_length的序列,输入张量形状为[num_batch, seq_length],输出这些序列接续的下一个字符的概率分布,概率分布的维度为字符种类数num_chars,输出张量形状为[num_batch, num_chars]。我们从下一个字符的概率分布中采样作为预测值,然后滚雪球式地生成下两个字符,下三个字符等等,即可完成文本的生成任务。

首先,还是实现一个简单的 DataLoader 类来读取文本,并以字符为单位进行编码。

class DataLoader():

def __init__(self):

path = tf.keras.utils.get_file('nietzsche.txt',

origin='https://s3.amazonaws.com/text-datasets/nietzsche.txt')

with open(path, encoding='utf-8') as f:

self.raw_text = f.read().lower()

self.chars = sorted(list(set(self.raw_text)))

self.char_indices = dict((c, i) for i, c in enumerate(self.chars))

self.indices_char = dict((i, c) for i, c in enumerate(self.chars))

self.text = [self.char_indices[c] for c in self.raw_text]

def get_batch(self, seq_length, batch_size):

seq = []

next_char = []

for i in range(batch_size):

index = np.random.randint(0, len(self.text) - seq_length)

seq.append(self.text[index:index+seq_length])

next_char.append(self.text[index+seq_length])

return np.array(seq), np.array(next_char) # [num_batch, seq_length], [num_batch]

接下来进行模型的实现。在 __init__ 方法中我们实例化一个常用的 BasicLSTMCell 单元,以及一个线性变换用的全连接层,我们首先对序列进行One Hot操作,即将编码i变换为一个n维向量,其第i位为1,其余均为0。这里n为字符种类数num_char。变换后的序列张量形状为[num_batch, seq_length, num_chars]。接下来,我们将序列从头到尾依序送入RNN单元,即将当前时间t的RNN单元状态 state 和t时刻的序列 inputs[:, t, :] 送入RNN单元,得到当前时间的输出 output 和下一个时间t+1的RNN单元状态。取RNN单元最后一次的输出,通过全连接层变换到num_chars维,即作为模型的输出。

具体实现如下:

class RNN(tf.keras.Model):

def __init__(self, num_chars):

super().__init__()

self.num_chars = num_chars

self.cell = tf.nn.rnn_cell.BasicLSTMCell(num_units=256)

self.dense = tf.keras.layers.Dense(units=self.num_chars)

def call(self, inputs):

batch_size, seq_length = tf.shape(inputs)

inputs = tf.one_hot(inputs, depth=self.num_chars) # [batch_size, seq_length, num_chars]

state = self.cell.zero_state(batch_size=batch_size, dtype=tf.float32)

for t in range(seq_length.numpy()):

output, state = self.cell(inputs[:, t, :], state)

output = self.dense(output)

return output

训练过程与前节基本一致,在此复述:

- 从DataLoader中随机取一批训练数据;

- 将这批数据送入模型,计算出模型的预测值;

- 将模型预测值与真实值进行比较,计算损失函数(loss);

- 计算损失函数关于模型变量的导数;

- 使用优化器更新模型参数以最小化损失函数。

data_loader = DataLoader()

model = RNN(len(data_loader.chars))

optimizer = tf.train.AdamOptimizer(learning_rate=learning_rate)

for batch_index in range(num_batches):

X, y = data_loader.get_batch(seq_length, batch_size)

with tf.GradientTape() as tape:

y_logit_pred = model(X)

loss = tf.losses.sparse_softmax_cross_entropy(labels=y, logits=y_logit_pred)

print("batch %d: loss %f" % (batch_index, loss.numpy()))

grads = tape.gradient(loss, model.variables)

optimizer.apply_gradients(grads_and_vars=zip(grads, model.variables))

关于文本生成的过程有一点需要特别注意。之前,我们一直使用 tf.argmax() 函数,将对应概率最大的值作为预测值。然而对于文本生成而言,这样的预测方式过于绝对,会使得生成的文本失去丰富性。于是,我们使用 np.random.choice() 函数按照生成的概率分布取样。这样,即使是对应概率较小的字符,也有机会被取样到。同时,我们加入一个 temperature 参数控制分布的形状,参数值越大则分布越平缓(最大值和最小值的差值越小),生成文本的丰富度越高;参数值越小则分布越陡峭,生成文本的丰富度越低。

def predict(self, inputs, temperature=1.):

batch_size, _ = tf.shape(inputs)

logits = self(inputs)

prob = tf.nn.softmax(logits / temperature).numpy()

return np.array([np.random.choice(self.num_chars, p=prob[i, :])

for i in range(batch_size.numpy())])

通过这种方式进行“滚雪球”式的连续预测,即可得到生成文本。

X_, _ = data_loader.get_batch(seq_length, 1)

for diversity in [0.2, 0.5, 1.0, 1.2]:

X = X_

print("diversity %f:" % diversity)

for t in range(400):

y_pred = model.predict(X, diversity)

print(data_loader.indices_char[y_pred[0]], end='', flush=True)

X = np.concatenate([X[:, 1:], np.expand_dims(y_pred, axis=1)], axis=-1)

生成的文本如下:

diversity 0.200000:

conserted and conseive to the conterned to it is a self--and seast and the selfes as a seast the expecience and and and the self--and the sered is a the enderself and the sersed and as a the concertion of the series of the self in the self--and the serse and and the seried enes and seast and the sense and the eadure to the self and the present and as a to the self--and the seligious and the enders

diversity 0.500000:

can is reast to as a seligut and the complesed

has fool which the self as it is a the beasing and us immery and seese for entoured underself of the seless and the sired a mears and everyther to out every sone thes and reapres and seralise as a streed liees of the serse to pease the cersess of the selung the elie one of the were as we and man one were perser has persines and conceity of all self-el

diversity 1.000000:

entoles by

their lisevers de weltaale, arh pesylmered, and so jejurted count have foursies as is

descinty iamo; to semplization refold, we dancey or theicks-welf--atolitious on his

such which

here

oth idey of pire master, ie gerw their endwit in ids, is an trees constenved mase commars is leed mad decemshime to the mor the elige. the fedies (byun their ope wopperfitious--antile and the it as the f

diversity 1.200000:

cain, elvotidue, madehoublesily

inselfy!--ie the rads incults of to prusely le]enfes patuateded:.--a coud--theiritibaior "nrallysengleswout peessparify oonsgoscess teemind thenry ansken suprerial mus, cigitioum: 4reas. whouph: who

eved

arn inneves to sya" natorne. hag open reals whicame oderedte,[fingo is

zisternethta simalfule dereeg hesls lang-lyes thas quiin turjentimy; periaspedey tomm--whach

| [2] | 此处的任务及实现参考了 https://github.com/keras-team/keras/blob/master/examples/lstm_text_generation.py |

深度强化学习(DRL)¶

强化学习 (Reinforcement learning,RL)强调如何基于环境而行动,以取得最大化的预期利益。结合了深度学习技术后的强化学习更是如虎添翼。这两年广为人知的AlphaGo即是深度强化学习的典型应用。深度强化学习的基础知识可参考:

这里,我们使用深度强化学习玩CartPole(平衡杆)游戏。简单说,我们需要让模型控制杆的左右运动,以让其一直保持竖直平衡状态。

我们使用 OpenAI推出的Gym环境库 中的CartPole游戏环境,具体安装步骤和教程可参考 官方文档 和 这里 。Gym的基本调用方法如下:

import gym

env = gym.make('CartPole-v1') # 实例化一个游戏环境,参数为游戏名称

state = env.reset() # 初始化环境,获得初始状态

while True:

env.render() # 对当前帧进行渲染,绘图到屏幕

action = model.predict(state) # 假设我们有一个训练好的模型,能够通过当前状态预测出这时应该进行的动作

next_state, reward, done, info = env.step(action) # 让环境执行动作,获得执行完动作的下一个状态,动作的奖励,游戏是否已结束以及额外信息

if done: # 如果游戏结束则退出循环

break

那么,我们的任务就是训练出一个模型,能够根据当前的状态预测出应该进行的一个好的动作。粗略地说,一个好的动作应当能够最大化整个游戏过程中获得的奖励之和,这也是强化学习的目标。

以下代码展示了如何使用深度强化学习中的Deep Q-Learning方法来训练模型。

import tensorflow as tf

import numpy as np

import gym

import random

from collections import deque

tf.enable_eager_execution()

num_episodes = 500

num_exploration_episodes = 100

max_len_episode = 1000

batch_size = 32

learning_rate = 1e-3

gamma = 1.

initial_epsilon = 1.

final_epsilon = 0.01

# Q-network用于拟合Q函数,和前节的多层感知机类似。输入state,输出各个action下的Q-value(CartPole下为2维)。

class QNetwork(tf.keras.Model):

def __init__(self):

super().__init__()

self.dense1 = tf.keras.layers.Dense(units=24, activation=tf.nn.relu)

self.dense2 = tf.keras.layers.Dense(units=24, activation=tf.nn.relu)

self.dense3 = tf.keras.layers.Dense(units=2)

def call(self, inputs):

x = self.dense1(inputs)

x = self.dense2(x)

x = self.dense3(x)

return x

def predict(self, inputs):

q_values = self(inputs)

return tf.argmax(q_values, axis=-1)

env = gym.make('CartPole-v1') # 实例化一个游戏环境,参数为游戏名称

model = QNetwork()

optimizer = tf.train.AdamOptimizer(learning_rate=learning_rate)

replay_buffer = deque(maxlen=10000)

epsilon = initial_epsilon

for episode_id in range(num_episodes):

state = env.reset() # 初始化环境,获得初始状态

epsilon = max(

initial_epsilon * (num_exploration_episodes - episode_id) / num_exploration_episodes,

final_epsilon)

for t in range(max_len_episode):

env.render() # 对当前帧进行渲染,绘图到屏幕

if random.random() < epsilon: # epsilon-greedy探索策略

action = env.action_space.sample() # 以epsilon的概率选择随机动作

else:

action = model.predict(

tf.constant(np.expand_dims(state, axis=0), dtype=tf.float32)).numpy()

action = action[0]

next_state, reward, done, info = env.step(action) # 让环境执行动作,获得执行完动作的下一个状态,动作的奖励,游戏是否已结束以及额外信息

reward = -10. if done else reward # 如果游戏Game Over,给予大的负奖励

replay_buffer.append((state, action, reward, next_state, 1 if done else 0)) # 将(state, action, reward, next_state)的四元组(外加done标签表示是否结束)放入经验重放池

state = next_state

if done: # 游戏结束则退出本轮循环,进行下一个episode

print("episode %d, epsilon %f, score %d" % (episode_id, epsilon, t))

break

if len(replay_buffer) >= batch_size:

# 从经验回放池中随机取一个batch的四元组,并分别转换为NumPy数组

batch_state, batch_action, batch_reward, batch_next_state, batch_done = zip(

*random.sample(replay_buffer, batch_size))

batch_state, batch_reward, batch_next_state, batch_done = \

[np.array(a, dtype=np.float32) for a in [batch_state, batch_reward, batch_next_state, batch_done]]

batch_action = np.array(batch_action, dtype=np.int32)

q_value = model(tf.constant(batch_next_state, dtype=tf.float32))

y = batch_reward + (gamma * tf.reduce_max(q_value, axis=1)) * (1 - batch_done) # 按照论文计算y值

with tf.GradientTape() as tape:

loss = tf.losses.mean_squared_error( # 最小化y和Q-value的距离

labels=y,

predictions=tf.reduce_sum(model(tf.constant(batch_state)) *

tf.one_hot(batch_action, depth=2), axis=1)

)

grads = tape.gradient(loss, model.variables)

optimizer.apply_gradients(grads_and_vars=zip(grads, model.variables)) # 计算梯度并更新参数

自定义层 *¶

可能你还会问,如果现有的这些层无法满足我的要求,我需要定义自己的层怎么办?

事实上,我们不仅可以继承 tf.keras.Model 编写自己的模型类,也可以继承 tf.keras.layers.Layer 编写自己的层。

class MyLayer(tf.keras.layers.Layer):

def __init__(self):

super().__init__()

# 初始化代码

def build(self, input_shape): # input_shape 是一个 TensorShape 类型对象,提供输入的形状

# 在第一次使用该层的时候调用该部分代码,在这里创建变量可以使得变量的形状自适应输入的形状

# 而不需要使用者额外指定变量形状。

# 如果已经可以完全确定变量的形状,也可以在__init__部分创建变量

self.variable_0 = self.add_variable(...)

self.variable_1 = self.add_variable(...)

def call(self, input):

# 模型调用的代码(处理输入并返回输出)

return output

例如,如果我们要自己实现一个 本章第一节 中的全连接层,但指定输出维度为1,可以按如下方式编写,在 build 方法中创建两个变量,并在 call 方法中使用创建的变量进行运算:

class LinearLayer(tf.keras.layers.Layer):

def __init__(self):

super().__init__()

def build(self, input_shape): # here input_shape is a TensorShape

self.w = self.add_variable(name='w',

shape=[input_shape[-1], 1], initializer=tf.zeros_initializer())

self.b = self.add_variable(name='b',

shape=[1], initializer=tf.zeros_initializer())

def call(self, X):

y_pred = tf.matmul(X, self.w) + self.b

return y_pred

使用相同的方式,可以调用我们自定义的层 LinearLayer:

class Linear(tf.keras.Model):

def __init__(self):

super().__init__()

self.layer = LinearLayer()

def call(self, input):

output = self.layer(input)

return output

Graph Execution模式 *¶

事实上,只要在编写模型的时候稍加注意,以上的模型都是可以同时兼容Eager Execution模式和Graph Execution模式的 [3] 。注意,在Graph Execution模式下, model(input_tensor) 只需运行一次以完成图的建立操作。

例如,通过以下代码,同样可以调用 本章第一节 建立的线性模型并进行线性回归:

model = Linear()

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.01)

X_placeholder = tf.placeholder(name='X', shape=[None, 3], dtype=tf.float32)

y_placeholder = tf.placeholder(name='y', shape=[None, 1], dtype=tf.float32)

y_pred = model(X_placeholder)

loss = tf.reduce_mean(tf.square(y_pred - y_placeholder))

train_op = optimizer.minimize(loss)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

for i in range(100):

sess.run(train_op, feed_dict={X_placeholder: X, y_placeholder: y})

print(sess.run(model.variables))

| [3] | 除了本章实现的RNN模型以外。在RNN模型的实现中,我们通过Eager Execution动态获取了seq_length的长度,使得我们可以方便地动态控制RNN的展开长度。然而Graph Execution不支持这一点,为了达到相同的效果,我们需要固定seq_length的长度,或者使用 tf.nn.dynamic_rnn ( 文档 )。 |

| [LeCun1998] |

|

| [Graves2013] | Graves, Alex. “Generating Sequences With Recurrent Neural Networks.” ArXiv:1308.0850 [Cs], August 4, 2013. http://arxiv.org/abs/1308.0850. |

| [Mnih2013] | Mnih, Volodymyr, Koray Kavukcuoglu, David Silver, Alex Graves, Ioannis Antonoglou, Daan Wierstra, and Martin Riedmiller. “Playing Atari with Deep Reinforcement Learning.” ArXiv:1312.5602 [Cs], December 19, 2013. http://arxiv.org/abs/1312.5602. |